ニューラルネットワークはいかにして「記憶」できるのか?

記憶の生成や保存といった複雑な情報を研究するには、コンピュータモデルの活用が重要となります。しかし、このようなモデルの構築は容易ではありません。脳では生化学的、電気的な信号が複雑に作用しあい、神経細胞と他の種類の細胞間の接続が絡み合うことで記憶を定着させていますが、神経科学では脳の根本的な生物学的な解明が十分でないため、このプロセスをコンピュータモデルに落とし込んで研究を進めることが困難でした。

このたび、沖縄科学技術大学院大学(OIST)の研究チームは、「ホップフィールドネットワーク」という記憶に関する一般的なコンピュータモデルを、最近の生物学的知見に基づいて改良し、性能を向上させました。この新しいネットワークモデルにより、神経細胞やその他の細胞が脳内でどのように結合しているかをより正確に示すだけでなく、一般的なモデルよりもはるかに多くの記憶を保持できることを発見しました。

深井朋樹教授が率いる神経情報・脳計算ユニットに所属する博士課程学生トーマス・バーンズさんは、次のように述べています。「ネットワークモデルを複雑化したことで、実際的なものに近づきました。生物は、なぜこれほどまでに複雑なのか。その理由は、記憶容量にあるかもしれません。」

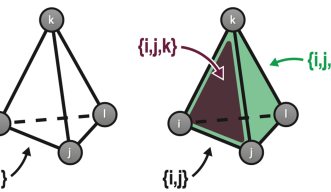

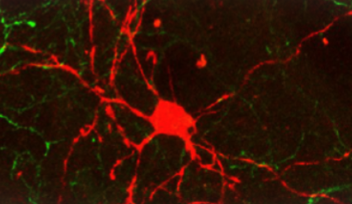

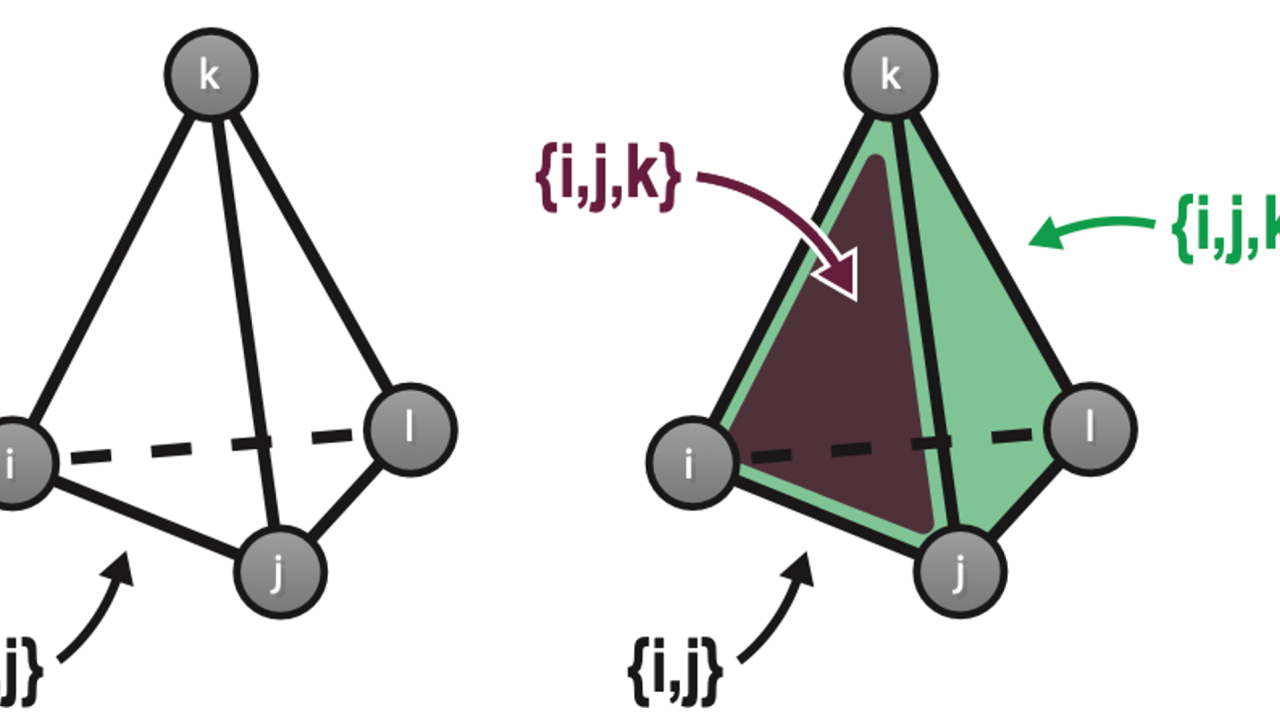

ホップフィールドネットワークでは、神経細胞がさまざまな強さ(重み)で結合しており、記憶はその結合パターンとして保存されます。これらのパターンをエンコードするようネットワークは「訓練」されます。そのネットワークに不明瞭または不完全なパターンを提示し、見覚えのあるパターンとしてネットワークに認識されるかどうかを調べることにより、記憶力をテストすることができます。従来のホップフィールドネットワークのモデルでは、神経細胞が対で結合して「ペアワイズ結合」を形成します。ペアワイズ結合は、脳内の2つの神経細胞がシナプスという接合部でつながっている状態を表しますが、実際の神経細胞は、樹状突起という複雑に枝分かれした構造を持っており、複数の接合部があります。つまり、実際の脳ではシナプスがはるかに複雑につながる事によって認知機能を発揮しています。さらに、神経細胞間の結合はアストロサイト(星状細胞)という別の種類の細胞によって調節されています。

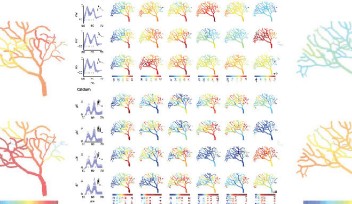

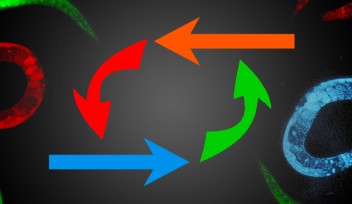

「脳内で神経細胞同士がペアワイズ結合だけでつながっていると考えるのは、現実的ではありません」と説明するバーンズさんは、ホップフィールドネットワークに改良を加えて、神経細胞が対だけでなく、3つ組、4つ組、またはそれ以上の組み合わせでシナプス結合を形成する、アストロサイトや樹状突起を介して脳で実現していると思われる状態を表現しました。この新しいネットワークは、いわゆる「セットワイズ」結合を可能にしますがが、全体としての結合数は以前と同じままに保たれます。研究チームは、ペアワイズ結合とセットワイズ結合の両方を含むネットワークが最もよく機能し、保持できる記憶状態数も最大となることを発見しました。このネットワークは、従来のホップフィールドネットワークの2倍以上機能向上を果たすと見積もっています。バーンズさんは、次のように述べています。「色々な要素をバランスよく組み合わせる必要があることがわかりました。個々のシナプスだけでなく、樹状突起やアストロサイトも必要です。」

ホップフィールドネットワークは、脳の情報処理のモデルとして重要ですが、それ以外でも非常に有用です。例えば、ChatGPTなどのAIによる言語処理ツールには、トランスフォーマーと呼ばれる非常によく似たタイプのネットワークが使われています。つまり、こうしたツールにバーンズさんと深井教授が行った改良を適用すると、より強固なツールになる可能性があります。

バーンズさんをはじめとする研究チームは、改良したホップフィールドネットワークのさらなる強化に向けて今後も研究を続けていく予定です。脳では通常、神経細胞間の結合の強さは、双方向で同じではありません。バーンズさんは、この非対称性という特徴もネットワークの性能の向上に関係しているのではないかと考えています。さらに、人間の脳で行われているように、ネットワークの記憶同士が相互作用する仕方も探ってみたいと考えています。「私たちの記憶は、多面的で膨大です。まだまだ解明すべきことがたくさんあります」と、バーンズさんは述べています。

本研究論文「Simplicial Hopfield Networks」は、International Conference on Learning Representationsで発表されます。

論文情報

専門分野

研究ユニット

広報・取材に関するお問い合わせ

報道関係者専用問い合わせフォーム