研究の目的

近年の人工ニューラルネットワークや機械学習の発展により、 学習能力を持ったロボットや人工エージェントなどが開発されるようになりました。 しかしロボットにうまく学習させるためには、(1) メタパラメータ、(2) 報酬関数、 (3) 状態表現、(4) 学習アルゴリズムなどを注意深く設計しなければなりません。

実現されている人工システムでは、 それらのパラメータを設計者が試行錯誤を通して設定していましたが、 人間やそれ以外の動物は多様に変化する環境化においても新しい行動を次々と学習しているように思えます。

適応システムグループの目的は、 実際の生物と同じ制約条件を持つ人工エージェントに必要な神経メカニズムを解明することです。

サイバーローデントとは

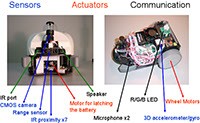

実際の生物と同じ自己保存と自己複製という条件のもとで、 生存し交配するロボット「サイバーローデント」を開発しました。 体長 22 センチ、重さ 1.75 キログラムのロボットで、 全方位視覚システム、近接距離センサ、加速度センサ、 ジャイロセンサなど多様なセンサを持っています。

車輪による移動機構のほかに、三色 LED を用いて内部状態を外部に表出することができます。 サイバーローデントには二つの大きな特徴があります。 一つは自己保存能力で、 前方正面に取り付けられた電極と環境中におかれた電池パックを接触させることで、 自身のバッテリを充電することができます。 もう一つの特徴として、 サイバーローデントは赤外線通信を用いてロボット間で制御プログラムを交換することが可能です。 これは実際の生物における交配行動に対応します。

研究課題

私たちはロボティクス、機械学習、統計学習、 計算論的神経科学などの知見をもとにさまざまな事柄を研究しています。 テーマは

- 学習器の構造の獲得、

- 強化学習におけるメタパラメータの学習および進化、

- 報酬関数の学習および進化、

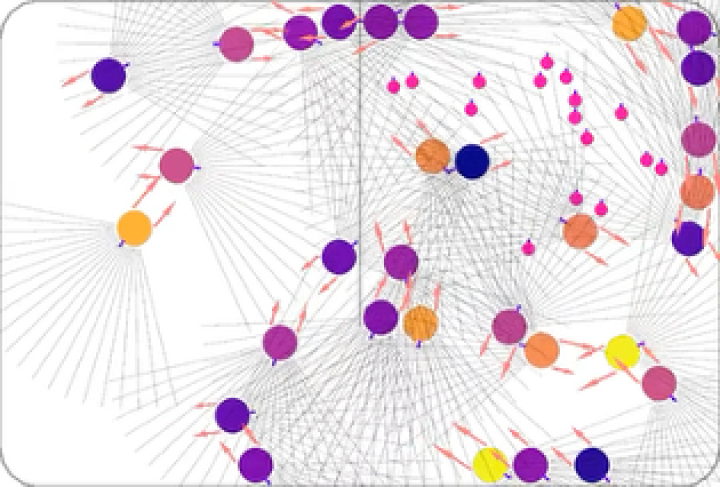

- 並列強化学習システム、

- 方策勾配強化学習における自然勾配の利用。

出版物

出版物のページを参照ください。